Siempre me han fascinado las falacias de tecnoutópicos y tecnodistópicos, los unos siempre a punto de olvidar, por ejemplo, la historia y los puntos negativos de lo que tenemos actualmente, y los otros dispuestos a olvidar la historia (sí, también) y los puntos positivos… Como el artículo, para ser de una revista académica, es bastante interesante, os recomiendo encarecidamente su lectura en su versión original (también tenéis el texto subrayado por mí, si queréis, cortesía de Diigo). Una vez acabado de leer, y viendo que el subrayado tenía una cierta coherencia, me he animado a traducirlo para los que seáis más bien alérgicos a la lengua de Shakespeare. Son tres mil y pico palabras (aseguro que el original es bastante más largo), pero su lectura no debería ser demasiado pesada y, os lo aseguro, contiene unas cuantas joyitas de valor :-).

[…]

Para entender cómo nuestras vidas están ya profundamente formadas por la tecnología, debemos tener en cuenta la información no sólo en términos abstractos de terabytes y zettabytes, sino también en términos más culturales. ¿Cómo las tecnologías a las que han dado forma los seres humanos para interactuar con el mundo acaban, a su vez, dándonos forma a nosotros? ¿Qué nos hacen estas tecnologías, que son de nuestra propia creación y elementos irreductibles de nuestro propio ser? La tarea analítica yace en identificar y adoptar formas de acción humana particulares de nuestra era digital, sin reducir la tecnología a una mera extensión mecánica de lo humano, a una mera herramienta. En pocas palabras, preguntar si Google nos hace estúpidos, como algunos críticos culturales han hecho recientemente, es la pregunta equivocada. Asume distinciones entre los seres humanos y la tecnología que ya no son, si es que alguna vez lo fueron, sostenibles.

Dos narrativas

[…] Por un lado, hay quienes afirman que los esfuerzos de digitalización de Google, el poder de las redes sociales de Facebook y la era del big data en general están finalmente haciendo realidad el viejo sueño de unificar todo el conocimiento. […] Estas afirmaciones utópicas se relacionan con visiones similares sobre un futuro transhumanista en el que la tecnología superará los que fueron los límites históricos de la humanidad: físicos, intelectuales y psicológicos. El sueño es de una era posthumana.

Por otro lado, observadores menos optimistas interpretan la llegada de la digitalización y del big data como augurios de una edad de la sobrecarga informacional. […] A muchos les preocupa que los hipervínculos de la web que nos lanzan de una página a otra, los blogs que reducen largos artículos a una más consumible línea o dos y los tweets que condensan pensamientos a 140 caracteres han creado una cultura de la distracción. Las mismas tecnologías que nos ayudan a gestionar toda esta información socavan nuestra capacidad para leer con ninguna profundidad o cuidado. […] Como dice Nicholas Carr, «lo que la Red parece estar haciendo es minar mi capacidad de concentración y contemplación. Mi mente espera ahora absorber información tal y como la Red la distribuye: en un rapidísimo flujo de partículas en movimiento». […] Para Carr y muchos otros como él, el verdadero conocimiento es profundo y su profundidad es proporcional a la intensidad de nuestra atención. En nuestro mundo digital que alienta la cantidad sobre la calidad, Google nos está volviendo estúpidos.

[…] Ambas narrativas, sin embargo, cometen dos errores básicos.

En primer lugar, imaginan que nuestra era de la información no tiene precedentes, pero las explosiones de la información y las declaraciones utópicas y apocalípticas que las acompañan son una vieja preocupación. La aparición de toda nueva tecnología de la información trae consigo nuevos métodos y modos de almacenar y transmitir cada vez más información, y estas tecnologías afectan profundamente la forma en que los humanos interactúamos con el mundo. […]

En segundo lugar, ambas narrativas cometen un error conceptual fundamental al aislar los efectos causales de la tecnología. Las tecnologías, sea el libro impreso, sea Google, no nos hacen ilimitadamente libres o ni incansablemente estúpidos. […] Las afirmaciones simples respecto a los efectos de la tecnología ocultan supuestos básicos, para bien o para mal, sobre la tecnología como causa independiente que eclipsa el resto de causas. Asumen que los efectos de la tecnología puede ser fácilmente aislados y abstraídos de su contexto social e histórico.

[…]

En este sentido, la tecnología no es ni un diluvio abstracto de datos ni un simple apéndice mecánico subordinado a las intenciones humanas, sino la manera misma en que el ser humano participa en el mundo. Celebrar la Web, o cualquier otra tecnología, como inherentemente edificante o embrutecedora es ignorar su dimensión más humana. […] Del mismo modo, sugerir que Google nos está volviendo estúpidos es ignorar el hecho histórico de que con el tiempo las tecnologías han tenido un efecto en nuestra forma de pensar, pero de maneras mucho más complejos y en absoluto reducible a afirmaciones simples.

[…] Las tecnologías digitales hacen la Web accesible haciéndola parecer mucho más pequeña y manejable de lo que imaginamos que es. La Web no existe. En este sentido, la historia de la sobrecarga informacional es instructiva menos por lo que nos enseña acerca de la cantidad de información que por lo qie nos enseña acerca de cómo las tecnologías que diseñamos para interactuar con el mundo nos dan forma a nosotros a su vez. […]

[…] Carr y otros críticos de las formas con que interactúamos con nuestras tecnologías digitales tienen buenas razones para estar preocupados, pero, como espero demostrar, por razones bastante diferentes de las que podrían pensar. La cuestión central no se refiere a modos particulares de acomodar las nuevas tecnologías, sino a nuestra propia concepción de la relación entre el ser humano y la tecnología.

Demasiados libros

Como la historiadora Ann Blair ha demostrado recientemente, nuestras preocupaciones contemporáneas sobre la sobrecarga informacional resuenan con las reclamaciones históricas sobre «demasiados libros.» […] Eclesiastés 12:12, «De hacer libros no hay fin» […] Séneca, «la abundancia de libros es una distracción» […] Leibniz, la «horrible masa de libros sigue creciendo». […]

Las quejas sobre exceso de libros experimentaron una mayor urgencia en el transcurso del siglo XVIII, cuando explotó el mercado del libro, especialmente en Inglaterra, Francia y Alemania. Mientras que hoy en día nos imaginamos a nosotros mismos engullidos por una avalancha de datos digitales, a finales del siglo XVIII los lectores alemanes, por ejemplo, se imaginaban infestados por una plaga de libros [Bücherseuche]. […]

[…] En 1702 el jurista y filósofo Christian Thomasius expuso algunas de las preocupaciones normativas que ganarían tracción a lo largo del siglo. Describió la escritura y el negocio de los libros como una especie de enfermedad epidémica que ha afligido Europa durante mucho tiempo, y es más apropiada para llenar los almacenes de los libreros que las bibliotecas de los eruditos. Cualquiera podría entender que esto es resultado del deseo de escribir libros que aflige a las personas actualmente. Hasta ahora nadie sino los sabios, o al menos los que deben ser considerados así, se entrometía con este tema, pero hoy en día no hay nada más común, se extiende a través de todas las profesiones, de modo que ahora casi hasta los zapateros remendones, y las mujeres que apenas pueden leer, tienen la ambición de ser impresos, y puede que los veamos llevando sus libros de puerta en puerta, como un vendedor ambulante hace con sus cajas de peines, pasadores y cordones

.

El surgimiento de un mercado de libros impresos rebajó el listón de entrada para los autores y poco a poco comenzó a hacer los filtros y las limitaciones tradicionales de la producción de libros cada vez más inadecuados. La percepción de un exceso de libros fue motivada por un supuesto más básico acerca de quién debería o no escribirlos.

[…] En su escrito de 1975, Llamada a mi Nación: Sobre la Plaga de Libros Alemanes, el librero y editor alemán Johann Georg Heinzmann lamentaba que ningún país ha impreso tanto como los alemanes

. Para Heinzmann, los lectores alemanes de finales del siglo XVIII sufrían bajo un «reinado de los libros» en el que eran peones involuntarios de ideas que no eran las suyas. Dando a esta ansiedad cultural un marco filosófico, y ganando a Carr por más de dos siglos, Immanuel Kant se quejaba de que tal superabundancia de libros animaba a la gente a «leer mucho» y «superficialmente». La lectura extensiva no sólo fomentaba malos hábitos de lectura, sino que también causaba una condición patológica más general, la Belesenheit [la calidad de ser muy leído], ya que exponía a los lectores a un gran «desperdicio» [Verderb] de los libros. Cultivaba el pensamiento acrítico.

[…]

De manera no tan diferente a los lectores contemporáneos con sus herramientas digitales, los lectores alemanes del siglo XVIII tenían una gama de tecnologías y métodos a su disposición para hacer frente a la proliferación de libros —diccionarios, bibliografías, revistas, tomar notas, enciclopedias, anotaciones en los márgenes, «commonplace books«, notas al pie. Estas tecnologías hicieron las cantidades crecientes de impresión más manejables ayudando a los lectores a seleccionar, resumir y organizar un almacén cada vez mayor de información. La enorme gama de tecnologías demuestra que los seres humanos suelen tratar la sobrecarga informacional a través de soluciones creativas y a veces sorprendentes que desdibujan la línea entre los humanos y la tecnología.

[…] Una tecnología de búsqueda relacionada, la concordancia bíblica —las primeras se remontan a 1247— indexaba cada palabra de la Biblia y facilitaba su uso más amplio en los sermones y, después de sus traducciones a la lengua vernácula, a un público aún más amplio. Del mismo modo, los índices se hicieron cada vez más populares y grandes argumentos de venta de textos impresos en el siglo XVI.

[…] Para principios del siglo XVIII había incluso una ciencia dedicada a la organización y la contabilidad de todas estas tecnologías y libros: la historia literaria. […]

[…]

Mientras muchos lectores abrumados daban la bienvenida a estas técnicas y tecnologías, algunos, sobre todo a finales del siglo XVIII, comenzaron a quejarse de que conducían a una forma de conocimiento derivativa, de segunda mano. […] J.G. Herder, se mofaba de los franceses por sus intentos de hacer frente a tal proliferación de libros con enciclopedias: Ahora se crean enciclopedias, hasta Diderot y D’Alembert se han rebajado a ello. Y ese libro que es un triunfo para los franceses es para nosotros la primera señal de su decadencia. No tienen nada que escribir y, por tanto, crean abregés, vocabularios, esprits, enciclopedias— las obras originales desaparecen

.

Haciéndose eco de las preocupaciones contemporáneas acerca de cómo nuestra dependencia de Google y la Wikipedia podrían llevar a formas superficiales de conocimiento, Herder se preocupaba de que estas tecnologías reducían el conocimiento a unidades discretas de información. […]

A mediados del siglo XVIII la palabra «erudito» —utilizada anteriormente para describir de forma positiva a una persona educada— se convirtió en sinónimo de diletante, alguien que simplemente ojeaba, agregaba y acumulaba montones de información, pero que nunca aprendía mucho de ello. En suma, enciclopedias y similares habían reducido el proyecto de la Ilustración, afirmaban los críticos, a mera gestión de la información. Estaba en juego la definición de «verdadero» conocimiento. […]

Como sugiere esta breve historia de tecnologías de la información de la Ilustración, afirmar que una tecnología en particular tiene un efecto único, ya sea positivo o negativo, es reducir a la vez histórica y conceptualmente el complejo nexo causal dentro del que los seres humanos y las tecnologías interactúan y se dan forma mutuamente. Loss reciente y generalmente bien recibidos argumentos de Carr preguntándose si Google nos vuelve estúpidos, por ejemplo, se basan en un paralelo histórico que se dibuja con la era de la impresión. Afirma que la invención de la imprenta causó una forma de lectura más intensa y, por extrapolación, la imprenta causó una forma más reflexiva de pensamiento —las palabras sobre la página centraban al lector.

Históricamente hablando, esto es tecnodeterminismo hiperbólico. Carr supone que las tecnologías simplemente «determinan nuestra situación», independientemente de los seres humanos, mientras que esas mismas tecnologías, métodos y medios de comunicación emergen de situaciones históricas particulares con su propio complejo de factores. […]

Argumentos como los de Carr […] también tienden a ignorar el hecho de que, históricamente, la imprenta facilitó una serie de hábitos y estilos de lectura. Francis Bacon, propenso a condenar los libros impresos, hablaba de al menos tres formas de leer libros: «Algunos libros son para ser probados, otros para ser engullidos, y algunos pocos para ser masticados y digeridos.» Como bastantes académicos han demostrado últimamente, diferentes formas de lectura coexistieron en la era de la imprenta. […] Incluso la forma de lectura intensiva considerada hoy una práctica moribunda, la lectura de novelas, fue ridiculizada a menudo en el siglo XVIII como un debilitamiento de la memoria que conduce a la «distracción habitual», como afirmó Kant. Se consideraba especialmente peligroso para las mujeres que, según Kant, ya eran propensas a formas inferiores de pensamiento. […]

[…] Tales reducciones omiten el hecho de que Google y la tecnología de la imprenta no operan independientemente de los humanos que los diseñan, interactúan con ellos y constantemente los modifican, al igual que los seres humanos no existen independientemente de las tecnologías. Al centrarse en la capacidad de la tecnología para determinar el ser humano (insistiendo en que Google nos vuelve estúpidos, que la impresión nos convierte en lectores más profundos), corremos el riesgo de perder de vista cuán profundamente nuestra propia agencia está envuelta de tecnología. […] Enfatizar un vínculo causal simple y directo entre la tecnología y una forma particular de pensar es aislar la tecnología de las formas de vida con que está ligada.

[…]

La nota al pie: de Kant a Google

Hoy en día las herramientas más comunes para organizar el conocimiento son algoritmos y estructuras de datos. A menudo imaginamos que no tienen precedente. Pero los motores de búsqueda de Google se aprovechan de una tecnología bastante antigua: la cosa más académica y aparentemente inútil, la nota al pie. […] Resulta que [los] enlaces digitales tienen un antecedente revelador histórico y conceptual en la nota al pie de la Ilustración.

El moderno hipervínculo y la nota al pie de la Ilustración comparten una lógica que se basa en suposiciones acerca de la naturaleza basada en texto del conocimiento. Ambos asumen que los documentos, los textos impresos del siglo XVIII o los digitalizados del siglo XXI, son la base del conocimiento. […]

[…] La lógica citacional de la Ilustración es fundamentalmente autorreferencial y recursiva —es decir, los criterios de juicio vienen siempre dados por el propio sistema de textos y no algo externo, como autoridad divina o eclesiástica. El valor y la autoridad de un texto se establecen por el hecho de que otros textos apuntan a él. Cuantas más notas al pie apuntan a un texto en particular, este adquiere mayor autoridad por el hecho de que otros textos le apuntan.

[…]

[…] La autoridad, relevancia y valor de un texto se sostenían —tanto conceptual como visualmente— por una serie de notas que apuntaban a otros textos. Como nuestros hipervínculos contemporáneos, estas citas interrumpían el flujo de la lectura —a menudo marcadas con un gran asterisco o un «consulte la página 516.» Tal vez más importante, sin embargo, es que todas estas notas al pie y citas no apuntaban a un único texto inspirado divinamente o autorizado, sino a una red mucho más amplia de textos. Las notas al pie y citas eran las fibras que conectaban y coordinaban una gran cantidad de textos impresos. […]

La Lógica Citacional de Google

Los fundadores de Google, Larry Page y Sergey Brin, modelaron su revolucionario motor de búsqueda en la lógica citacional de la nota al pie y por lo tanto traspusieron muchos de sus supuestos sobre el conocimiento y la tecnología a un medio digital. Google «organiza la información del mundo,» como dice su lema, modelando la estructura de hipervínculos inherente a la web basada en documentos. […]

Page y Brin partieron de la idea de que la web «se basaba libremente en la premisa de la citación y anotación —al fin y al cabo, ¿qué es un enlace, sino una citación, y qué es el texto que describe ese vínculo, sino una nota?» El propio Page veía esta lógica citacional como la clave para modelar la estructura propia de la Web. La cita académica moderna es simplemente la práctica de señalar el trabajo de los demás, de forma muy similar a la nota al pie. […]

[…]

El Yo Algorítmico

[…] Al resaltar las analogías entre Google y la cultura de la imprenta de la Ilustración he tratado de resistirme al alarmismo y la visión utópica que tienden a enmarcar las discusiones actuales sobre la cultura digital, en primer lugar por poner en un marco histórico estas preocupaciones y, en segundo, demostrando que la tecnología debe ser entendida en conexión profundida y corpórea con lo humano. Considerada en estos términos, la cuestión de si Google nos está volviendo estúpidos o inteligentes podría dar paso a preguntas más complejas y productivas. […]

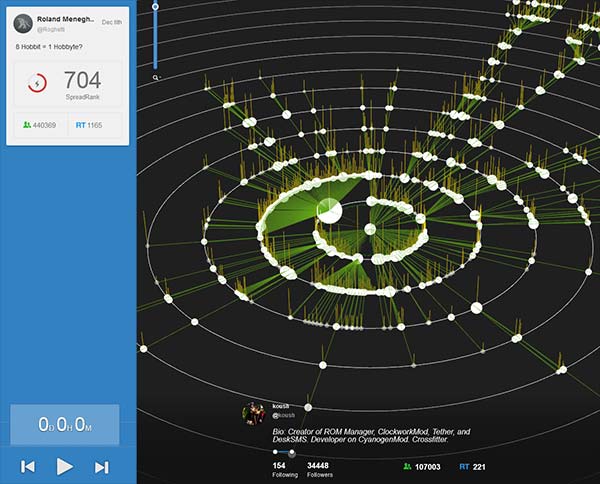

[…] Cada vez que hacemos clic, escribimos un término de búsqueda o actualizamos nuestro estado en Facebook, la red cambia un poco. «Puede que Google no nos esté volviendo estúpidos, pero nosotros lo estamos volviendo (y a Facebook) más inteligente», porque toda la información con que alimentamos a ambos cada día. […]

Pensando más en términos de una ecología o medio ambiente digital y menos en una dicotomía de ser humano versus tecnología, podemos entender la Web, como James Hendler, Tim Berners-Lee y colegas han dicho recientemente, no sólo como una máquina aislada «para ser diseñada para mejorar su rendimiento «, sino como un «fenómeno con el que nos relacionamos». Escriben «en la escala micro, la Web es una infraestructura de lenguajes y protocolos artificiales; es una obra de ingeniería. Sin embargo, es la interacción de los seres humanos que crean, enlazan y consumen información la que genera el comportamiento de la Web como propiedades emergentes en la escala macro».

[…]

Por otro lado, los seres humanos individuales son agentes centrales en las operaciones de Google porque crean hipervínculos. Columnistas como Paul Krugman y Peggy Noonan toman decisiones sobre qué enlazar o no en sus columnas. Del mismo modo, a medida que hacemos clic de un enlace a otro (o elegimos no hacer clic), también decidimos y juzgamos sobre el valor de un enlace, y por tanto del documento que lo hospeda.

Como los algoritmos aumentan la escala de las operaciones procesando millones de enlaces, sin embargo, ocultan este elemento más humano de la Web. Todas esas decisiones de enlazar desde una página particular a la siguiente, de hacer clic de un enlace a otro implica no sólo un algoritmo alimentado por enlaces, sino por cientos de millones de seres humanos que interactúan con Google cada minuto. Estas son las interacciones humanas que tienen un impacto en la Web en el nivel macro, y quedan ocultas por las promesas de la caja de búsqueda de Google.

Sólo en este nivel macro de análisis podemos entender el hecho de que los algoritmos de búsqueda de Google no funcionan en una absoluta pureza mecánica, libre de interferencia externa. Sólo si entendemos la web y nuestras tecnologías de búsqueda y filtrado como elementos de una ecología digital podemos dar sentido a las propiedades emergentes de las complejas interacciones entre humanos y tecnología: engañar al sistema de Google a través de estrategias de optimización de búsqueda, las decisiones de empleados de Google (no algoritmos) de censurar ciertas páginas web y dar privilegios a otras (¿nunca han notado el predominio relativamente reciente de las páginas de Wikipedia en las búsquedas de Google?). La Web no es sólo una tecnología, sino una ecología de interacción hombre-tecnología. Es una cultura dinámica con sus propias normas y prácticas.

Las nuevas tecnologías, ya sea la enciclopedia impresa o la Wikipedia, no son máquinas abstractas que nos vuelven estúpidos o inteligentes por sí mismas. Como hemos visto con las tecnologías de lectura de la Ilustración, el conocimiento surge de complejos procesos de selección, distinción y juicio: de las interacciones irreducibles de los seres humanos y la tecnología. Debemos resistirnos a la falsa promesa que la caja vacía debajo del logotipo de Google ha venido a representar, sea esta acceso inmediato al conocimiento puro o una vida de distracción e información superficial. Se trata de un ardid. El conocimiento es difícil de ganar, diseñado, creado y organizado por los seres humanos y sus tecnologías. Los algoritmos de búsqueda de Google son sólo la más reciente de una larga historia de tecnologías que los seres humanos han desarrollado para organizar, evaluar y participar en su mundo.